Il crawl budget è un concetto fondamentale nella SEO, anche se spesso viene frainteso. In parole semplici, rappresenta la quantità di tempo e di risorse che Google dedica alla scansione di un sito web.

Immaginate Googlebot, il “ragno” di Google, come un esploratore digitale con un tempo limitato per visitare le pagine del vostro sito. Più tempo Googlebot trascorre sul vostro sito, maggiori sono le possibilità che le vostre pagine vengano scansionate e indicizzate, rendendole visibili nei risultati di ricerca.

Un crawl budget ottimizzato può portare a una serie di vantaggi per il vostro sito, tra cui un miglior posizionamento, un’indicizzazione più rapida dei contenuti e una maggiore visibilità organica. Al contrario, se Googlebot spreca tempo prezioso su pagine di bassa qualità, duplicate o irrilevanti, le vostre pagine più importanti potrebbero non ricevere l’attenzione che meritano.

Approfondiamo insieme, e cerchiamo di capire cos’è il crawl budget, quali fattori lo influenzano e come ottimizzarlo per massimizzare il potenziale SEO di un sito web.

Che cos’è il Crawl Budget?

Con l’espressione crawl budget si fa riferimento alla quantità di tempo e risorse che Google dedica alla scansione delle pagine di un sito web. Non è un numero fisso, ma piuttosto una combinazione di fattori che determinano la frequenza e la profondità di scansione di Googlebot, il crawler di Google.

Esso è determinato da due elementi principali: il crawl rate e la crawl demand.

Il crawl rate si riferisce alla velocità con cui Googlebot scansiona un sito web. In altre parole, indica quante pagine Googlebot può elaborare in un dato periodo di tempo. Google regola il crawl rate per evitare di sovraccaricare il server del sito web e garantire un’esperienza utente positiva.

Diversi fattori possono influenzare questo parametro:

- stato di salute del server: un sito web con un server lento o che presenta errori frequenti avrà un crawl rate inferiore;

- limiti impostati in search Console: è possibile impostare un limite al crawl rate in Search Console, ma questo non significa necessariamente che Googlebot scansionerà il sito più frequentemente;

- protezione del sito: Googlebot cerca di non sovraccaricare i server per non interferire con l’esperienza degli utenti.

La crawl demand, invece, si riferisce alla frequenza con cui Googlebot scansiona un sito web in base alla sua importanza percepita. Più un sito web è considerato importante da Google, più frequentemente verrà scansionato.

I fattori che influenzano la crawl demand sono i seguenti:

- inventario: Googlebot cerca di scansionare tutti gli URL noti su un sito web. Se il sito contiene molti URL duplicati o non necessari, Googlebot potrebbe impiegare più tempo a scansionarli, riducendo l’efficienza del crawl budget;

- popolarità: gli URL più popolari su internet vengono scansionati più frequentemente per garantire che il loro contenuto nell’indice di Google sia aggiornato;

- mancato aggiornamento: Googlebot scansiona periodicamente i documenti per rilevare eventuali modifiche;

- freschezza dei contenuti: un sito web che pubblica nuovi contenuti frequentemente avrà una crawl demand maggiore rispetto a un sito web con contenuti statici;

- qualità dei contenuti: Googlebot dà priorità alla scansione di siti web con contenuti di alta qualità e pertinenti.

In sintesi, anche se un sito web può tecnicamente gestire un crawl rate elevato, se la crawl demand è bassa, la frequenza di scansione sarà comunque inferiore. La chiave per ottimizzare il crawl budget è quindi sia garantire che il sito web sia tecnicamente pronto per una scansione efficiente sia aumentare il valore dei contenuti per gli utenti e, di conseguenza, per Google.

In che modo il crawl budget influenza la SEO?

Il crawl budget svolge un ruolo cruciale nel determinare l’efficacia della vostra strategia SEO. Se ottimizzato, può portare a significativi miglioramenti nella visibilità del vostro sito web sui motori di ricerca.

Nello specifico, può favorire:

- il miglioramento del posizionamento generale: quando Googlebot scansiona e indicizza le pagine del vostro sito web in modo efficiente, i motori di ricerca sono in grado di comprendere meglio la struttura e il contenuto del sito, il che può portare a un miglioramento del posizionamento generale nelle pagine dei risultati di ricerca (SERP);

- una indicizzazione più rapida dei nuovi contenuti: se Googlebot visita frequentemente il vostro sito web e dispone di un budget sufficiente per scansionare tutte le pagine, i vostri nuovi contenuti, come articoli del blog o pagine di prodotti, verranno indicizzati più rapidamente, rendendoli visibili agli utenti che effettuano ricerche pertinenti in tempi brevi;

- l’aumento della visibilità organica: un crawl budget ottimizzato consente a Googlebot di scoprire e indicizzare un maggior numero di pagine del vostro sito, aumentando la vostra visibilità complessiva nei risultati di ricerca organici. Questo può portare a un aumento del traffico organico, ovvero visitatori che arrivano al vostro sito web tramite i motori di ricerca.

Al contrario, un crawl budget mal gestito può avere conseguenze negative per la SEO:

- spreco di risorse su pagine di bassa qualità: se Googlebot dedica gran parte del suo budget alla scansione di pagine con contenuti duplicati, irrilevanti o di bassa qualità, le vostre pagine più importanti potrebbero non essere scansionate e indicizzate correttamente;

- indicizzazione ritardata o mancata delle pagine importanti: se Googlebot non riesce a scansionare le vostre pagine più importanti a causa di un budget limitato o di una struttura del sito inefficiente, queste pagine potrebbero non essere indicizzate affatto o essere indicizzate con un ritardo significativo, compromettendo la loro visibilità nei risultati di ricerca.

Gestire il crawl budget in modo efficace significa fare in modo che Googlebot si concentri sulle pagine giuste, quelle che portano traffico qualificato e generano risultati concreti.

Il crawl budget è importante per il mio sito web?

ll crawl budget è importante per il proprio sito web se rientra in una di queste categorie:

- siti di grandi dimensioni (oltre un milione di pagine univoche) con contenuti che cambiano con una certa frequenza (una volta a settimana);

- siti di medie o grandi dimensioni (oltre 10.000 pagine univoche) con contenuti che cambiano molto spesso (ogni giorno);

- siti con una porzione consistente di URL totali classificati da Search Console come “Rilevata, ma attualmente non indicizzata”.

Se il sito web non rientra in queste categorie, è probabile che Google riesca a scansionarlo e indicizzarlo in modo efficiente senza che ci si debba preoccupare eccessivamente del Crawl Budget. In questo caso, è sufficiente concentrarsi sulla creazione di contenuti di alta qualità, sull’ottimizzazione della velocità del sito e sul mantenimento di una struttura del sito pulita e organizzata.

Detto questo, anche se il sito web è di piccole dimensioni, ci sono alcuni casi in cui questo fattore può diventare rilevante:

- se abbiamo appena aggiunto un gran numero di nuove pagine al sito web;

- se il sito web ha molti reindirizzamenti;

- se il sito web presenta problemi tecnici che impediscono ai motori di ricerca di scansionarlo in modo efficiente.

In queste situazioni, ottimizzare il crawl budget può aiutare a garantire che le nuove pagine vengano indicizzate rapidamente e che Google non sprechi risorse su pagine irrilevanti o problematiche.

Come posso sapere se il mio sito web ha un problema di crawl budget?

Come si fa a capire se c’è un problema con il crawl budget? In effetti, è importante capire come identificare se il sito web soffre di problemi, e per farlo esistono alcuni segnali ai quali prestare attenzione:

- il sito web è di grandi dimensioni e ci mette molto tempo ad essere indicizzato o addirittura alcuni contenuti non vengono indicizzati affatto;

- Google Search Console riporta un numero elevato di pagine “Rilevate, ma attualmente non indicizzate”. Questo indica che Googlebot ha trovato le pagine, ma non le ha ancora indicizzate. Un numero elevato di pagine in questo stato potrebbe indicare che Googlebot non dispone di un budget sufficiente per scansionare tutto il tuo sito;

- improvviso calo del traffico organico. Potrebbe essere dovuto a diversi fattori, ma una delle possibili spiegazioni è proprio un problema di crawl budget;

- il sito web presenta molti errori, come pagine 404, reindirizzamenti errati e tempi di caricamento lenti, che impediscono a Googlebot di scansionare le pagine più importanti;

- Googlebot non sta scansionando le tue pagine più importanti con la frequenza desiderata. L’analisi dei log del server può fornire informazioni dettagliate sull’attività di Googlebot sul sito web e aiutarci a capire se sta scansionando le pagine giuste.

In presenza di uno o più di questi segnali, è consigliabile approfondire la questione.

Ecco alcuni strumenti da utilizzare a tale scopo:

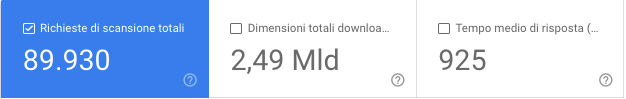

- Google Search Console: andando in “Impostazioni” -> “Statistiche di scansione”, è possibile prendere il dato fornito e calcolare la media delle pagine scansionate al giorno. Nello specifico, si deve dividere il numero di pagine totali del sito per il numero “Media scansionate al giorno”, ovvero il numero totale di richieste di scansione del tuo sito. Potrebbe essere necessario ottimizzare il Crawl Budget se si ottiene un numero superiore a ~10 (quindi si hanno 10 volte più pagine di quelle che Google scansiona quotidianamente);

- SEOZoom: la sezione “Rendimento Pagine” permette di identificare le pagine che consumano maggiormente il Crawl Budget senza contribuire significativamente al traffico organico;

- strumenti di analisi dei log: strumenti come Screaming Frog e Log File Analyzer permettono di analizzare i log del server per ottenere informazioni dettagliate sull’attività di Googlebot sul sito web.

Una volta analizzato il Crawl Budget del sito web, è possibile iniziare a ottimizzarlo.

Vediamo come.

Come posso ottimizzare il Crawl Budget del mio sito web?

Vediamo una serie di consigli su come ottimizzare il Crawl Budget del proprio sito web:

- migliorare la velocità del sito: Googlebot ha un tempo limitato per scansionare ogni sito web, quindi un sito veloce permette di scansionare più pagine. Si consiglia di migliorare la velocità del sito ottimizzando le immagini, riducendo plugin e script non necessari, scegliendo un hosting di qualità e abilitando la cache del browser;

- gestire l’inventario degli URL: assicurarsi che Googlebot non sprechi tempo a scansionare pagine inutili o duplicate;

- eliminare i contenuti duplicati: utilizzare il tag canonical per indicare la pagina principale in caso di contenuti simili o identici;

- utilizzare il file robots.txt per bloccare la scansione di pagine non importanti: ad esempio, pagine di login, pagine di ringraziamento, risultati di ricerca interni e pagine con contenuti duplicati. Bloccare gli URL con robots.txt riduce notevolmente la probabilità che vengano indicizzati;

- impostare un codice di stato 404 o 410 per le pagine rimosse: questo indica a Googlebot che la pagina non esiste più e non deve perdere tempo a scansionarla;

- eliminare gli errori soft 404: questi si verificano quando una pagina restituisce un codice di stato 200 (OK), ma non ha contenuti. Googlebot continuerà a scansionarle, sprecando risorse;

- non utilizzare il tag noindex per bloccare la scansione delle pagine: Googlebot scansionerà comunque le pagine con il tag noindex. Utilizzare il file robots.txt per bloccarle;

- ottimizzare la struttura del sito web: una struttura chiara facilita la navigazione e la scansione per Googlebot;

- creare una gerarchia di pagine chiara e logica: organizzare le pagine in categorie e sottocategorie è utile;

- utilizzare una struttura di URL semplice e descrittiva: gli URL dovrebbero essere facili da leggere e comprendere;

- utilizzare i link interni in modo strategico: i link interni aiutano Googlebot a scoprire nuove pagine e a capire la loro importanza;

- mantenere aggiornate le Sitemap: le Sitemap sono file XML che elencano le pagine del sito web, aiutando Googlebot a scoprirle e scansionarle. A tal proposito, ricordiamo di assicurarsi di aver creato una Sitemap XML e di averla inviata a Google Search Console, di aggiornarla quando si aggiungono o rimuovono pagine, e di includere solo gli URL canonici;

- monitorare la scansione del sito web: utilizzare Google Search Console per monitorare la scansione del sito e identificare i problemi. La summenzionata sezione “Statistiche di scansione” fornisce informazioni su:

- numero di pagine scansionate da Googlebot ogni giorno;

- eventuali errori riscontrati da Googlebot durante la scansione;

- velocità di risposta del server.

- concentrarsi sulla qualità dei contenuti: Google dà priorità ai siti con contenuti di alta qualità. Assicurarsi che i contenuti siano unici, informativi e utili per gli utenti. In caso di sito di grandi dimensioni con molte pagine simili, bisogna valutare se ha senso la loro esistenza o se è possibile raggruppare contenuti simili in una sola pagina;

- utilizzare il comando “disallow” nel file robots.txt: bloccare la scansione di directory inutili con milioni di URL con il comando “disallow” nel file robots.txt può liberare crawl budget, perché il bot si concentrerà su risorse più utili del sito.

L’ottimizzazione del Crawl Budget è un processo continuo, non basta un’azione una tantum per cambiare le cose. Si consiglia, quindi, di monitorare regolarmente l’attività di Googlebot sul proprio sito web e apportare le modifiche necessarie per garantire che il crawl budget venga utilizzato in modo efficiente.

Per approfondire, consigliamo la lettura della “Guida per i proprietari di siti di grandi dimensioni per la gestione del budget di scansione” di Google.